Thuật toán Co-LLM giúp mô hình AI đa năng hợp tác với LLM chuyên gia

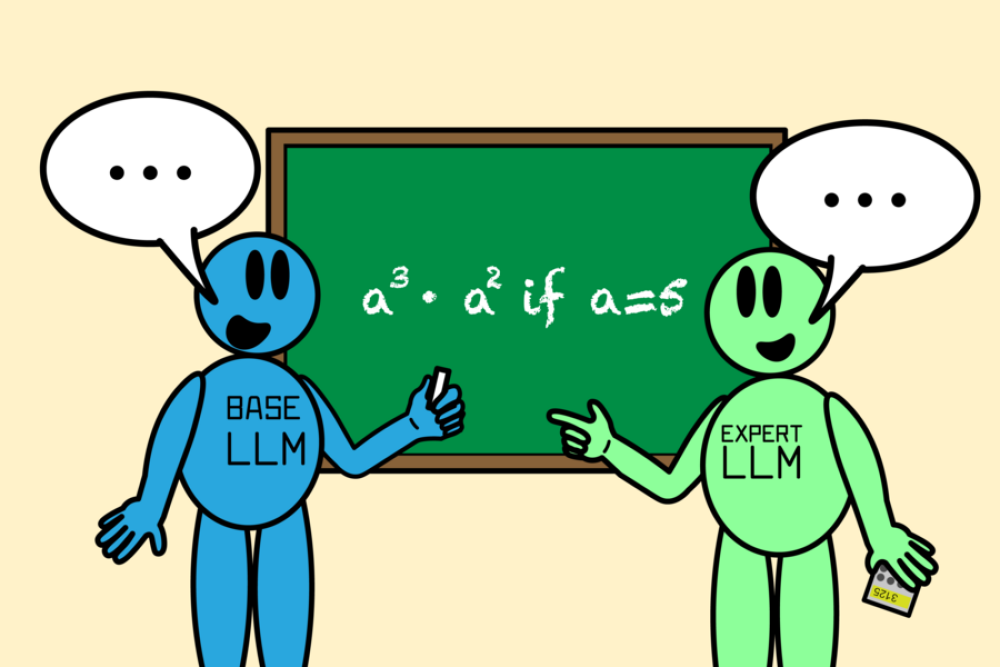

• Các nhà nghiên cứu tại MIT CSAIL đã phát triển thuật toán "Co-LLM" giúp mô hình ngôn ngữ lớn (LLM) đa năng hợp tác với mô hình chuyên gia để tạo ra câu trả lời chính xác hơn.

• Co-LLM hoạt động bằng cách xem xét từng từ trong câu trả lời của mô hình cơ bản và quyết định khi nào cần sử dụng câu trả lời chính xác hơn từ mô hình chuyên gia.

• Thuật toán sử dụng học máy để huấn luyện một "biến chuyển đổi", đóng vai trò như một người quản lý dự án, xác định khi nào cần gọi đến chuyên gia.

• Co-LLM đã được thử nghiệm với các bộ dữ liệu y sinh như BioASQ, kết hợp mô hình cơ bản với mô hình chuyên gia như Meditron.

• Khi giải quyết bài toán toán học, Co-LLM kết hợp mô hình đa năng với mô hình toán học lớn Llemma để đưa ra kết quả chính xác hơn.

• So với các phương pháp khác như "Proxy Tuning", Co-LLM có thể hướng dẫn hai mô hình được huấn luyện khác nhau làm việc cùng nhau.

• Co-LLM chỉ kích hoạt mô hình chuyên gia cho các token cụ thể, dẫn đến việc tạo câu trả lời hiệu quả hơn.

• Nhóm nghiên cứu đang xem xét phát triển phương pháp chuyển hướng mạnh mẽ hơn, cho phép Co-LLM điều chỉnh khi mô hình chuyên gia không đưa ra phản hồi chính xác.

• Họ cũng muốn cập nhật mô hình chuyên gia khi có thông tin mới, giúp câu trả lời luôn cập nhật nhất có thể.

• Trong tương lai, Co-LLM có thể hỗ trợ cập nhật tài liệu doanh nghiệp hoặc huấn luyện các mô hình nhỏ, riêng tư để làm việc với LLM mạnh mẽ hơn.

• Nghiên cứu được hỗ trợ bởi Quỹ Khoa học Quốc gia, Học bổng Sau đại học Khoa học và Kỹ thuật Quốc phòng Quốc gia (NDSEG), MIT-IBM Watson AI Lab và Amazon.

📌 Co-LLM là bước tiến quan trọng trong việc phát triển hệ sinh thái các mô hình chuyên biệt để vượt trội hơn các hệ thống AI đơn lẻ đắt đỏ. Thuật toán này cho phép ra quyết định ở cấp độ token, mang lại sự linh hoạt cao trong việc chuyển các bước tạo khó khăn cho mô hình mạnh hơn.

https://news.mit.edu/2024/enhancing-llm-collaboration-smarter-more-efficient-solutions-0916

#MIT

Thảo luận

Follow Us

Tin phổ biến