Tôn giáo công nghệ trỗi dậy: Lighthaven – “đền thờ AI” giữa lòng Silicon Valley

-

Một khách sạn cũ ở Berkeley, California đã được biến thành Lighthaven – trụ sở không chính thức của cộng đồng Rationalist, những người tin rằng AI có thể cứu hoặc hủy diệt nhân loại.

-

Khu phức hợp gồm 5 tòa nhà, công viên hoa hồng, tượng cổ điển, và các phòng họp giống như tu viện công nghệ, là nơi thường xuyên tổ chức hội thảo, họp nhóm và các nghi lễ đặc biệt.

-

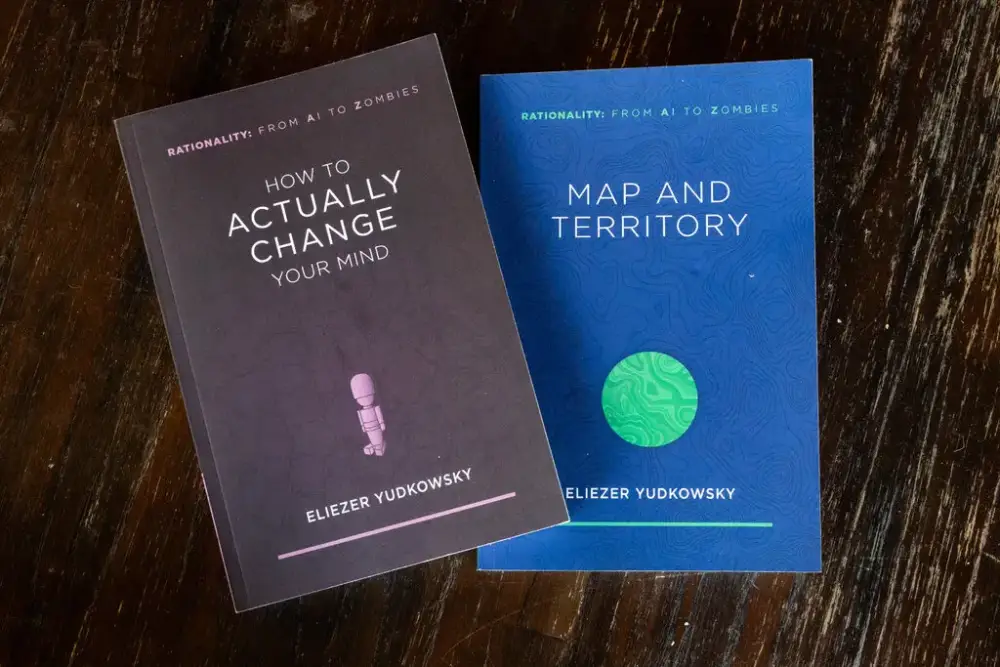

Rationalists khởi đầu từ các bài viết “The Sequences” của Eliezer Yudkowsky, kêu gọi tư duy xác suất, logic và cảnh báo sớm về rủi ro AI từ thập niên 2000.

-

Lighthaven là nơi kết nối chặt với phong trào Effective Altruism (E.A.), cùng chung lý tưởng sử dụng tài nguyên một cách hiệu quả nhất để cứu nhân loại khỏi diệt vong – trong đó AI là mối đe dọa ưu tiên.

-

Nhiều tên tuổi lớn trong AI như Dario Amodei (Anthropic), Shane Legg (DeepMind), Paul Christiano (Trung tâm Tiêu chuẩn AI Hoa Kỳ) đều từng chịu ảnh hưởng từ triết lý này.

-

Dự án MATS – chương trình đào tạo và kết nối vào ngành AI an toàn – tổ chức tại Lighthaven, đang thay thế học thuật truyền thống như cánh cửa vào lĩnh vực AI Ethics.

-

Sự kiện Solstice mùa đông trở thành lễ hội tinh thần hàng năm với nhạc, nghi lễ và cảnh báo tận thế: “Nếu chúng ta thất bại – 100% trẻ em sẽ chết, và nhân loại cũng vậy.”

-

Dù bị chỉ trích vì tư tưởng cực đoan, đa thê, và liên quan đến Sam Bankman-Fried, cộng đồng vẫn phát triển, với tài trợ từ các tỷ phú công nghệ như Jaan Tallinn (Skype).

-

Các ngôi nhà Rationalist lan rộng từ Mỹ đến châu Âu, và nhiều người ví Lighthaven như viện MIT Media Lab cho AI an toàn, với sức hút huyền thoại giống Dự án Manhattan thời xưa.

📌 Cộng đồng Rationalist đang biến việc phát triển AI thành một sứ mệnh gần như tôn giáo, với Lighthaven là "đền thờ" hiện đại. Bằng kết nối với các tỷ phú công nghệ và ảnh hưởng sâu sắc đến các lãnh đạo AI lớn, phong trào này không chỉ là triết lý sống mà còn là đòn bẩy quyền lực thật sự trong thế giới công nghệ hôm nay.

https://www.nytimes.com/2025/08/04/technology/rationalists-ai-lighthaven.html

Thảo luận

Follow Us

Tin phổ biến