xAI ra mắt Grok Code Fast 1: mô hình AI 314 tỷ tham số tối ưu cho agentic coding

-

Ngày 5/9/2025, xAI công bố grok-code-fast-1, mô hình AI mới thiết kế riêng cho agentic coding workflows.

-

Dữ liệu huấn luyện gồm kho lập trình lớn, cộng với giai đoạn hậu huấn luyện dựa trên pull request và nhiệm vụ thực tế.

-

Mô hình được tối ưu cho lệnh công cụ như grep, thao tác terminal và chỉnh sửa file, hỗ trợ tích hợp liền mạch với IDE và môi trường lập trình.

-

Tốc độ phản hồi cải thiện nhờ kỹ thuật prompt caching, đạt tỷ lệ trúng cache >90% trong workflow đối tác.

-

Hỗ trợ nhiều ngôn ngữ lập trình: TypeScript, Python, Java, Rust, C++, Go. Ứng dụng trong scaffold dự án, tra cứu codebase, sửa lỗi chính xác với ít giám sát.

-

Trên benchmark SWE-Bench-Verified, đạt 70,8% theo đánh giá nội bộ của xAI. Ngoài benchmark, nhóm phát triển còn dùng đánh giá con người và tự động để đảm bảo tính khả dụng thực tế.

-

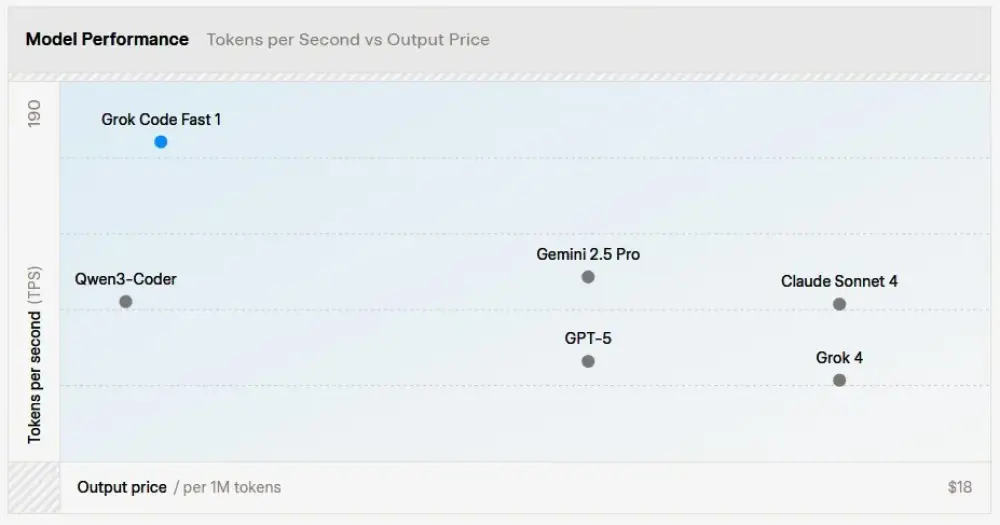

Kỹ thuật: cửa sổ ngữ cảnh 256k token, kiến trúc mixture-of-experts với 314 tỷ tham số, cân bằng giữa tốc độ và năng lực coding. Tốc độ thực tế: ~92 token/giây.

-

So sánh: o1-mini (OpenAI) và Claude Sonnet 3.5 (Anthropic) có độ chính xác cao hơn ở một số tác vụ, nhưng không đạt mức tối ưu về caching và throughput. Kiến trúc gần với Gemini 1.5 Pro của DeepMind, nhưng tập trung hoàn toàn cho lập trình.

-

Phản hồi cộng đồng: developer Eric Jiang ca ngợi tốc độ giúp tăng mạnh năng suất; Jonathan Parra mong có CLI để cạnh tranh với Claude Code.

-

Hiện grok-code-fast-1 được dùng miễn phí qua đối tác như GitHub Copilot, Cursor, Cline, Roo Code, Kilo Code, opencode, Windsurf. xAI dự kiến cập nhật thường xuyên và đang huấn luyện biến thể mới hỗ trợ multimodal, chạy song song nhiều công cụ và ngữ cảnh mở rộng.

📌 grok-code-fast-1 của xAI mang đến đột phá cho agentic coding: 314 tỷ tham số, ngữ cảnh 256k token và tốc độ 92 token/giây, đạt 70,8% trên SWE-Bench-Verified. Khác với đối thủ tập trung benchmark, mô hình ưu tiên tốc độ, tích hợp công cụ và tính ứng dụng thực tế. Hiện có thể dùng miễn phí qua GitHub Copilot và nhiều nền tảng khác, bản multimodal đang được huấn luyện.

https://www.infoq.com/news/2025/09/xai-grok-fast1/

Thảo luận

Follow Us

Tin phổ biến