XVERSE-MoE-A36B: thiết lập tiêu chuẩn mới trong kiến trúc Mixture-of-Experts

- XVERSE Technology đã công bố mô hình ngôn ngữ XVERSE-MoE-A36B, một bước tiến lớn trong lĩnh vực AI với khả năng đa ngôn ngữ.

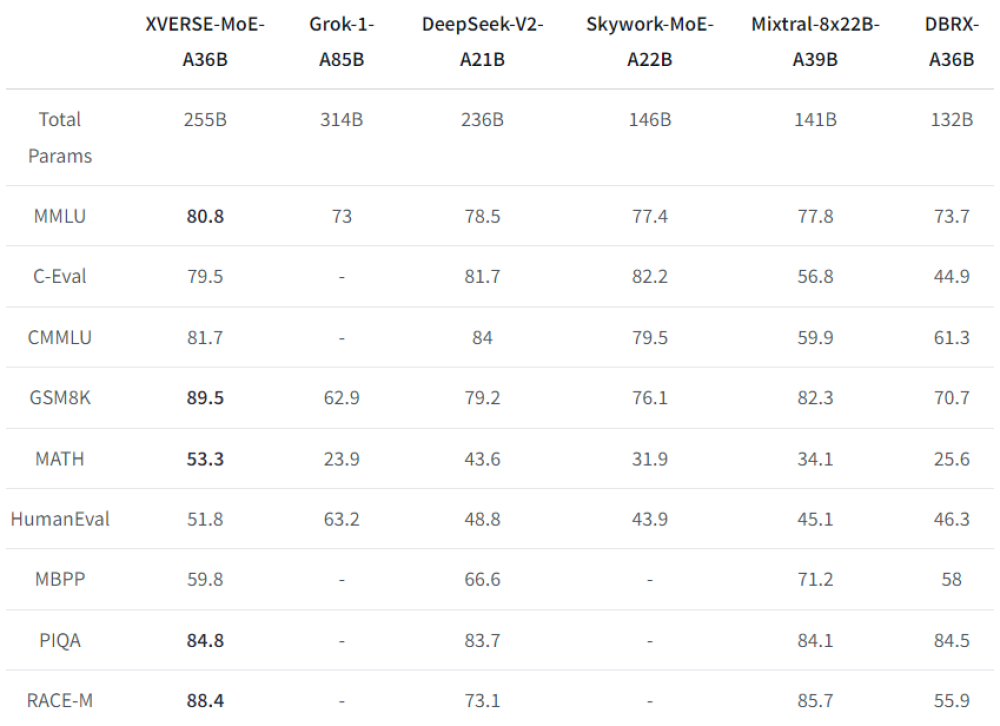

- Mô hình này sử dụng kiến trúc Mixture-of-Experts (MoE) với tổng số tham số lên tới 255 tỷ, trong đó 36 tỷ tham số được kích hoạt khi sử dụng.

- Kiến trúc MoE của XVERSE-MoE-A36B cho phép tối ưu hóa tài nguyên tính toán, nhờ vào cơ chế kích hoạt chọn lọc các chuyên gia.

- Mô hình này hỗ trợ hơn 40 ngôn ngữ, trong đó chú trọng vào tiếng Trung và tiếng Anh, giúp cải thiện hiệu suất ngôn ngữ.

- XVERSE-MoE-A36B sử dụng các tỷ lệ mẫu chính xác trong quá trình huấn luyện để đạt được kết quả xuất sắc trong các ngôn ngữ chính.

- Chiến lược huấn luyện của mô hình bao gồm cơ chế chuyển đổi dữ liệu động, giúp cập nhật liên tục các dữ liệu chất lượng cao.

- Mô hình cũng điều chỉnh lịch trình tốc độ học để nhanh chóng học từ dữ liệu mới mà không bị quá khớp.

- XVERSE Technology đã giải quyết các thách thức tính toán bằng cách sử dụng các chiến lược tính toán chồng chéo và kỹ thuật CPU-Offload.

- Mô hình đã được thử nghiệm trên nhiều chuẩn mực nổi tiếng như MMLU, C-Eval, và GSM8K, đạt được điểm số cao trong các bài kiểm tra.

- XVERSE-MoE-A36B có khả năng ứng dụng rộng rãi trong các lĩnh vực như hiểu ngôn ngữ tự nhiên, các tác nhân giao tiếp AI, và các lĩnh vực chuyên sâu như pháp lý và y tế.

- XVERSE Technology nhấn mạnh tầm quan trọng của việc sử dụng mô hình một cách có trách nhiệm, tránh phát tán nội dung độc hại hoặc thiên lệch.

- Công ty khuyến cáo người dùng nên thực hiện các bài kiểm tra an toàn trước khi triển khai mô hình trong các ứng dụng nhạy cảm.

📌 Mô hình XVERSE-MoE-A36B với 255 tỷ tham số và khả năng đa ngôn ngữ đã thiết lập tiêu chuẩn mới trong AI. Nó đạt điểm số xuất sắc trên nhiều chuẩn mực và hứa hẹn ứng dụng rộng rãi trong các lĩnh vực khác nhau, nhưng cần sử dụng một cách có trách nhiệm.

https://www.marktechpost.com/2024/09/15/xverse-moe-a36b-released-by-xverse-technology-a-revolutionary-multilingual-ai-model-setting-new-standards-in-mixture-of-experts-architecture-and-large-scale-language-processing/

Thảo luận

Follow Us

Tin phổ biến